Google每天至少使用一次Googlebot抓取工具来抓取网页并将其编入索引。通常,抓取基于您在Google Search Console中提交的XML Sitemap。但是,与普通内容网站相比,新闻网站的抓取频率可能会发生变化并且速度会更快。同样,Bing也使用Bingbot爬虫来爬取页面。一方面,网站管理员希望Google和Bing立即索引他们的页面,另一方面,在某些情况下,您必须阻止这些爬虫来停止爬取整个网站或您网站上的某些页面。

在本文中,我们将解释如何屏蔽Googlebot和Bingbot,屏蔽爬虫后会发生什么以及出现爬取问题的常见原因。

拦截Googlebot和Bingbot

根据您需要的严重程度,有多种方法可以阻止您的网页访问Google和Bing。

1. 使用Robots.txt进行拦截

阻止爬虫的最流行和最常见的方法是在robots.txt文件中使用指令。例如,插入以下行将拦截Google和Bing访问您网站上的页面。

Disallow: /your-page-url

User-agent: Bingbot

Disallow: /your-page-url

User-agent: Googlebot Disallow: /your-page-url User-agent: Bingbot Disallow: /your-page-url

尽管Google和Bing遵循robots.txt文件,但如果被阻止的页面是从另一篇已编入索引的文章链接的,它就不起作用。它可以来自您的网站,也可以来自您无法控制的外部网站。

2. 使用.htaccess来阻止

虽然不常见,但有些人更喜欢使用.htaccess指令来阻止爬虫。这类似于拦截Googlebot和Bingbot的IP地址,从而阻止对上述页面或目录的完全访问。

RewriteCond %{REQUEST_URI} ^/your-page-url

RewriteRule ^(.*)$ – [F,L]

RewriteEngine On

RewriteCond %{REQUEST_URI} ^/your-page-url

RewriteRule ^(.*)$ - [F,L]

3. 拦截Googlebot和Bingbot IP地址

上述方法的问题是您需要具有服务器访问权限才能编辑文件。此外,您在编辑robots.txt和.htaccess文件时也可能会出错。另一种有效的选择是使用阻止Googlebot和Bingbot IP地址。Google和Bing为爬虫提供更新后的IP地址,您可以将其用于阻止目的。这些IP地址采用JSON格式,您需要从中提取IP范围并使用。请记住,这些是用于Googlebot和Bingbot搜索爬虫,而不是用于其他目的,例如AdSense爬虫或Microsoft广告爬虫。

使用主机面板

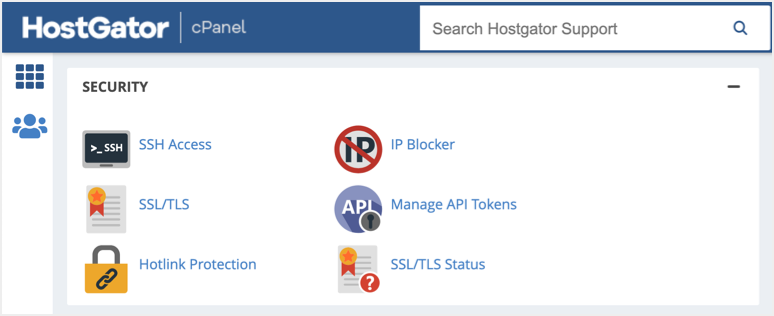

如果您有服务器访问权限,则可以使用主机面板中提供的IP Blocker工具。例如,HostGator在其cPanel的“SECURITY”部分下提供了一个名为IP Deny Manager的“IP Blocker”应用程序。

HostGator cPanel中的IP拦截器

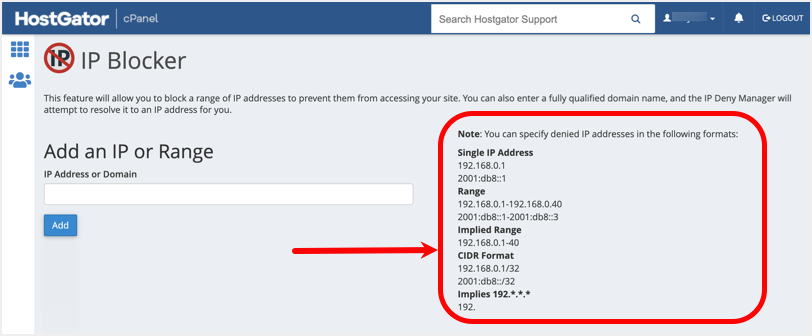

您可以在所有cPanel托管公司中找到类似的工具,例如Bluehost。单击IP Blocker应用程序并提供Googlebot或Bingbot的IP范围以拦截访问。例如,您可以使用以下方法之一提供Googlebot IP地址:

- 使用JSON文件中给出的CIDR格式,如 66.249.64.0/27。

- 隐含的IP范围,如 66.249.66.0-255

- 通配符范围如 66.249.*.*

- 只需输入googlebot.com,因为大多数Goolgebot用户代理都来自此主机名。

在cPanel中拦截Googlebot和Bingbot

通常,拦截一个或几个IP地址就足以拦截访问。但是,您可以使用通配符或主机名来阻止整个访问。

使用WordPress插件

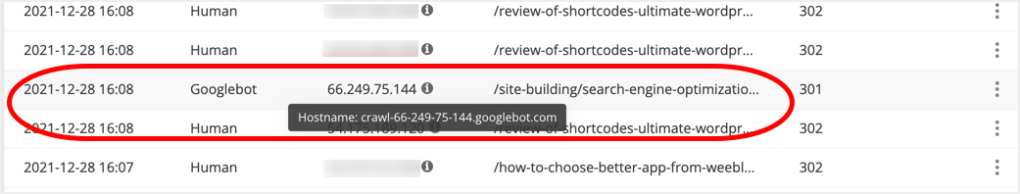

否则,如果您使用的是WordPress之类的内容管理系统,那么您有很多安全插件可以拦截来自站点管理员面板的机器人和IP地址,而无需访问托管帐户。例如,SiteGround Security插件允许您监控网站的实时流量。您可以根据用户代理名称找到Googlebot和 Bingbot IP地址,并在管理面板中单击几下即可阻止。

在SiteGround安全插件中拦截IP

这些是有效的方法,尤其是当您想拦截Google和Bing访问您的整个网站时。

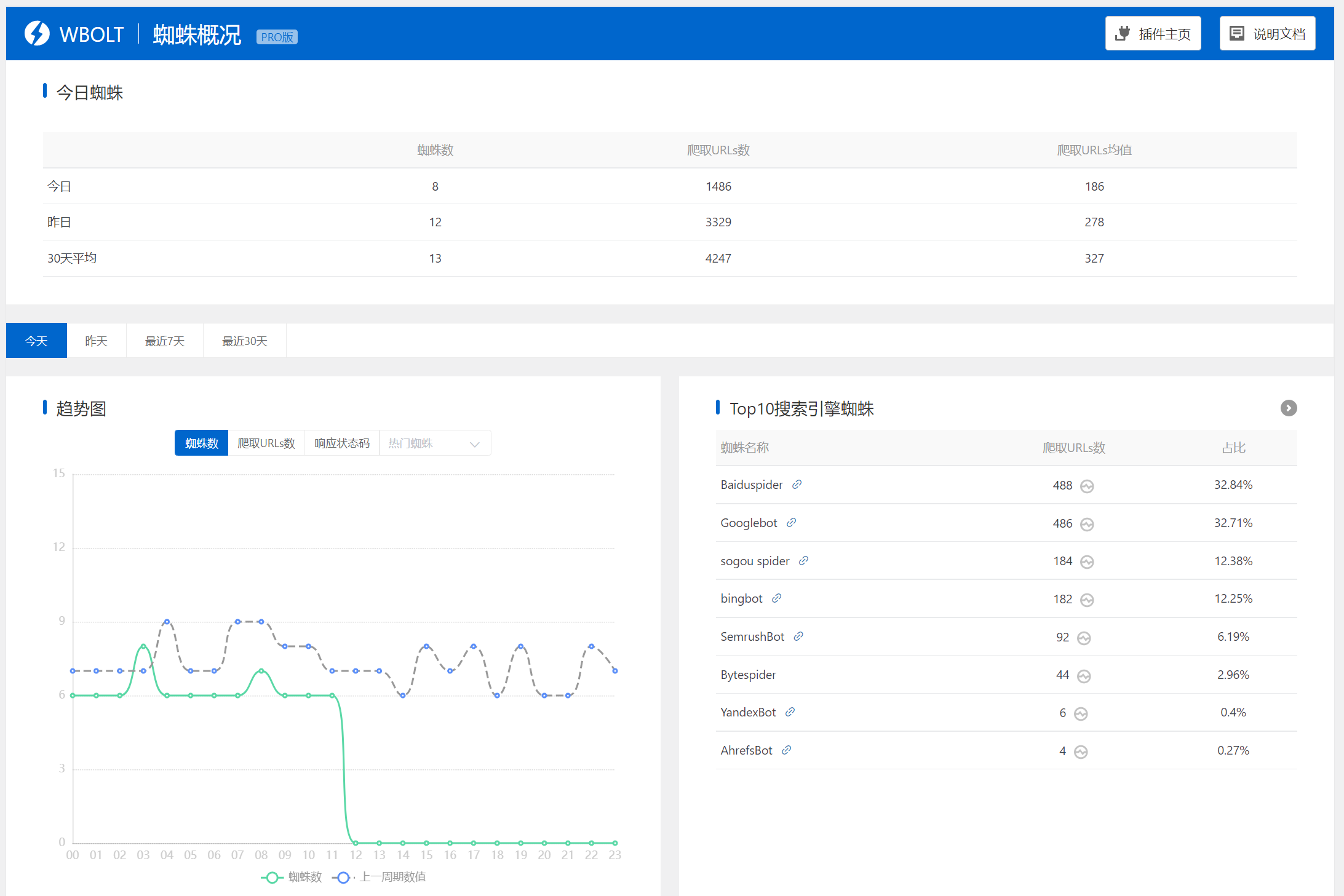

您还可以使用蜘蛛统计分析插件,通过插件的蜘蛛拦截功能来对Google和Bing蜘蛛进行拦截,您可以通过IP或者蜘蛛名进行快速拦截。

该插件同时还具备网站搜索引擎蜘蛛爬取数据统计,页面爬取日志查看,蜘蛛访问路径等功能,属于WordPress站长必不可少的SEO辅助插件。

4. 隐藏授权页面

这对于通过设置权限来限制搜索引擎对页面的访问非常有用。例如,银行和会员网站将个性化内容隐藏在登录授权后面,这样搜索引擎就无法访问这些内容。基于内容的机密性,您可能需要应用防火墙、阻止用户配置文件等。强烈建议聘请开发人员并在所需目录级别正确设置限制,以便Google不会抓取禁止部分。

控制爬行速率或爬行频率

如果您发现Googlebot和Bingbot对服务器资源的消耗较高,您可以控制抓取速度或抓取频率。抓取速度是Googlebot或Bingbot每秒发出的从您的网站获取内容的请求数。对于高流量网站,控制爬虫程序的爬取速度对于调整服务器资源至关重要。详细了解如何在Bing网站管理员工具中更改Bingbot的抓取速度。

但是,Google会自动使用优化的抓取速度从您的网站抓取内容。您可以从Google Search Console帐户查看此内容。如果您对当前的抓取频率不满意,请向Google提出特殊要求。新的抓取速度将在接下来的90天内有效,并在该期限后重置为优化设置。详细了解为什么您应该控制Googlebot抓取速度。

拦截Googlebot和Bingbot时会发生什么?

当您阻止页面或站点URL时,您将分别在Google Search Console和Bing网站管理员工具中看到不同类型的错误。以下是您会在Search Console帐户中注意到的一些常见错误:

- 当您使用robots.txt指令时,URL被Robots.txt阻止。

- 带有类似“提交的URL似乎是一个软404”的404错误消息 。

- 部分抓取或页面没有内容错误。

如果管理您网站的人错误地阻止了您网站上的页面,您可以检查“覆盖范围”部分下的Google Search Console错误并修复它们。

但是,在拦截IP或使用.htaccess方法时,您可能不会发现问题。简单的方法是使用Google Search Console中的URL检查工具、Google PageSpeed Insights或移动友好的测试工具来测试是否可以抓取实时页面。当Googlebot被阻止访问该页面时,您将看到错误和呈现的空白页面。

小结

您可以使用上述方法之一来拦截Googlebot和Bingbot抓取您的网站。但是,请确保在阻止您网站的特定页面或部分时避免错误。特别是,拦截IP地址是最危险的操作,它会将您的网页从Google搜索中完全删除。您可能需要重新提交页面并等待重新索引,这可能会导致流量下降,从而导致收入下降。因此,如果您不确定如何拦截Googlebot和Bingbot,请与您的托管公司联系。或者,聘请开发人员进行自定义开发工作,例如将机密内容隐藏在授权后面。