对于大多数营销人员来说,需要不断的更新来保持网站的新鲜度,并提高他们的SEO排名。

然而,有些网站有几百个甚至几千个页面,这对手工向搜索引擎推送更新的团队来说是一个挑战。如果内容更新如此频繁,团队如何确保这些改进对其SEO排名产生影响?

这就是爬虫机器人发挥作用的地方。一个网络爬虫机器人会搜刮你的网站地图,以获得新的更新,并将内容索引到搜索引擎。

在这篇文章中,我们将概述一个全面的爬虫列表,涵盖所有你需要知道的网络爬虫机器人。在我们深入讨论之前,让我们先定义网络爬虫机器人,并说明它们的功能。

- 什么是网络爬虫?

- 网络爬虫如何工作?

- 编制你的爬虫列表:什么是不同类型的网络爬虫?

- 添加到您的爬虫列表中的11种最常见的网络爬虫

- SEO专业人士需要了解的8种商业爬虫

- 我是否需要保护我的网站免受恶意网络爬虫的侵害?

什么是网络爬虫?

网络爬虫是一种计算机程序,它自动扫描并系统地读取网页,为搜索引擎编制网页索引。网络爬虫也被称为蜘蛛或机器人。

为了使搜索引擎向发起搜索的用户提供最新的、相关的网页,必须发生网络爬虫机器人的爬行。这个过程有时会自动发生(取决于爬虫和你网站的设置),也可以直接启动。

许多因素影响你的网页的SEO排名,包括相关性、反向链接、虚拟主机等等。然而,如果你的网页没有被搜索引擎抓取和索引,这些都不重要。这就是为什么确保你的网站允许正确的抓取,并消除任何阻碍它们的障碍是如此重要。

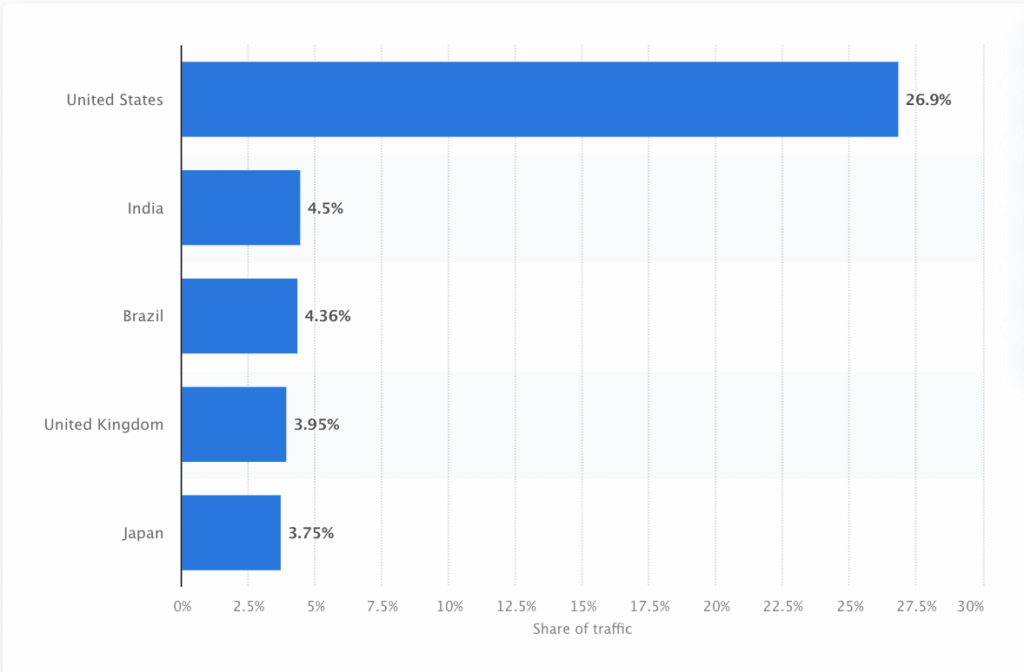

机器人必须不断地扫描和爬取网络,以确保呈现最准确的信息。谷歌是美国访问量最大的网站,大约26.9%的搜索来自美国用户。

谷歌搜索主要是从美国发起的(来源:Statista)

然而,并没有一个网络爬虫为每个搜索引擎抓取信息。每个搜索引擎都有独特的优势,所以开发人员和营销人员有时会编制一个 “爬虫列表”。这个爬虫列表有助于他们在网站日志中识别不同的爬虫,以便接受或阻止。

营销人员需要组装一个充满不同网络爬虫的爬虫列表,并了解它们如何评估他们的网站(与窃取内容的爬取者不同),以确保他们为搜索引擎正确优化登陆页面。

网络爬虫如何工作?

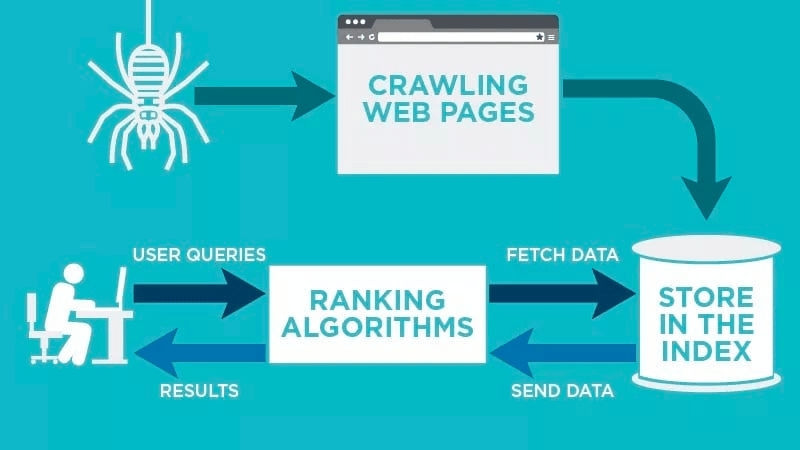

网络爬虫会在您的网页发布后自动扫描,并为您的数据编制索引。

网络爬虫寻找与网页相关的特定关键词,并为谷歌、必应等相关搜索引擎编制信息索引。

抓取网页是一个多步骤的过程 (Source: Neil Patel)

当用户提交与之相关的关键词的查询时,搜索引擎的算法将获取这些数据。

抓取从已知的URL开始。这些是已建立的网页,有各种信号将网络爬虫引向这些页面。这些信号可以是。

- 反向链接: 一个网站链接到它的次数

- 访客:前往该网页的流量有多大

- 域名权重:该域名的整体质量

然后,他们将数据存储在搜索引擎的索引中。当用户发起搜索查询时,算法将从索引中获取数据,并出现在搜索引擎结果页面上。这个过程可以在几毫秒内发生,这就是为什么结果经常迅速出现。

作为一个网站管理员,你可以控制哪些机器人抓取你的网站。这就是为什么拥有一个爬虫列表很重要。这是存在于每个网站服务器内的robots.txt协议,它将爬虫引向需要被索引的新内容。

根据你在每个网页的robots.txt协议中输入的内容,你可以告诉爬虫在将来扫描或避免索引该网页。

通过了解网络爬虫在其扫描中寻找的内容,你可以了解如何更好地为搜索引擎定位你的内容。

编制您的爬虫列表:什么是不同类型的网络爬虫?

当您开始考虑编制您的爬虫列表时,有三种主要的爬虫类型需要寻找。这包括:

- 内部爬虫:这些是由公司的开发团队设计的爬虫,用于扫描其网站。通常,它们用于网站审计和优化。

- 商业爬虫:这些是定制的爬虫,如Screaming Frog,公司可以用它来爬行并有效地评估其内容。

- 开源爬虫:这些是免费使用的爬虫,由世界各地的各种开发者和黑客构建。

了解现有的不同类型的爬虫很重要,这样你就知道你需要利用哪种类型来实现自己的商业目标。

添加到您的爬虫列表中的11种最常见的网络爬虫

没有一种爬虫可以为每个搜索引擎做所有的工作。

相反,有各种各样的网络爬虫来评估您的网页,并为全世界用户提供的所有搜索引擎扫描其内容。

让我们来看看今天一些最常见的网络爬虫。

1. Googlebot

Googlebot是谷歌的通用网络爬虫,负责抓取将在谷歌搜索引擎上显示的网站。

Googlebot对网站进行索引,以提供最新的谷歌结果

虽然技术上有两个版本的Googlebot–Googlebot Desktop和Googlebot Smartphone(Mobile)–但大多数专家认为Googlebot是一个单一的爬虫。

这是因为两者都遵循每个网站的robots.txt中写的相同的独特产品标记(称为用户代理标记)。Googlebot的用户代理只是 “Googlebot”。

Googlebot开始工作,通常每隔几秒钟就会访问你的网站(除非你在网站的robots.txt中阻止了它)。扫描过的页面的备份被保存在一个叫做Google Cache的统一的数据库中。这使你能够查看你网站的旧版本。

此外,Google Search Console也是站长们用来了解Googlebot如何抓取他们的网站,并对他们的网页进行搜索优化的另一个工具。

2. Bingbot

Bingbot是微软在2010年创建的,用于扫描和索引URL,以确保Bing为该平台的用户提供相关的、最新的搜索引擎结果。

Bingbot为Bing提供相关的搜索引擎结果

与Googlebot一样,开发者或营销人员可以在其网站的robots.txt中定义是否批准或拒绝代理标识符 “bingbot “扫描其网站。

此外,他们有能力区分移动优先索引的爬虫和桌面爬虫,因为Bingbot最近换成了新的代理类型。这与Bing网站管理员工具一起,为网站管理员提供了更大的灵活性,以显示他们的网站是如何在搜索结果中被发现和展示的。

3. Yandex Bot

Yandex Bot是专门针对俄罗斯搜索引擎Yandex的一个爬虫。这是在俄罗斯最大和最流行的搜索引擎之一。

Yandex Bot对俄罗斯搜索引擎Yandex进行索引

网站管理员可以通过robots.txt文件使Yandex Bot能够访问他们的网站页面。

此外,他们还可以在特定页面上添加Yandex.Metrica标签,在Yandex网站管理员中重新索引页面,或发布IndexNow协议,这是一份独特的报告,指出新的、修改过的或停用的页面。

4. Apple Bot

苹果公司委托Apple Bot为苹果的Siri和Spotlight建议抓取和索引网页。

Apple Bot是苹果公司Siri和Spotlight的网络爬虫

Apple Bot在决定将哪些内容提升到Siri和Spotlight建议中时,会考虑多种因素。这些因素包括用户参与、搜索词的相关性、链接的数量/质量、基于位置的信号,甚至是网页设计。

5. DuckDuck Bot

DuckDuckBot是DuckDuckGo的网络爬虫,它提供 “网络浏览器上的无缝隐私保护”。

DuckDuck Bot为注重隐私的网站进行爬行

网站管理员可以使用DuckDuckBot API来查看DuckDuck Bot是否已经抓取了他们的网站。随着它的抓取,它用最近的IP地址和用户代理更新DuckDuckBot API数据库。

这有助于网站管理员识别任何试图与DuckDuck Bot相关的冒名顶替者或恶意的机器人。

6. Baidu Spider

百度是中国领先的搜索引擎,而Baidu Spider是该网站唯一的爬虫。

百度蜘蛛是百度的爬虫,是一个中国的搜索引擎

谷歌在中国被禁止使用,因此,如果您想进入中国市场,启用百度蜘蛛抓取您的网站非常重要。

要识别抓取你的网站的百度蜘蛛,寻找以下用户代理:baiduspider、baiduspider-image、baiduspider-video,以及其他。

如果你不是在中国做生意,在你的 robots.txt 脚本中阻止百度蜘蛛可能是有意义的。这将阻止百度蜘蛛抓取你的网站,从而消除你的网页出现在百度搜索引擎结果页面(SERP)的任何机会。

7. Sogou Spider

搜狗是一个中文搜索引擎,据说是第一个拥有100亿中文网页索引的搜索引擎。

搜狗蜘蛛是搜狗的一个爬虫

如果你在中国市场开展业务,这是你需要了解的另一个流行的搜索引擎爬虫。搜狗蜘蛛遵循机器人的排他性文本和爬行延迟参数。

与百度蜘蛛一样,如果你不想在中国市场做生意,你应该禁用这个蜘蛛以防止网站加载时间过慢。

8. Facebook External Hit

Facebook External Hit,又称Facebook Crawler,抓取在Facebook上分享的应用程序或网站的HTML。

Facebook External Hit为链接分享索引网站

这使社交平台能够为平台上发布的每个链接生成一个可分享的预览。标题、描述和缩略图的出现得益于爬虫。

如果爬行没有在几秒钟内执行,Facebook将不会在分享前生成的自定义片段中显示内容。

9. Exabot

Exalead是一家创建于2000年的软件公司,总部设在法国巴黎。该公司为消费者和企业客户提供搜索平台。

Exabot是Exalead的爬虫,是一家搜索平台公司

Exabot是他们建立在CloudView产品上的核心搜索引擎的抓取器。

像大多数搜索引擎一样,Exalead在排名时同时考虑反向链接和网页上的内容。Exabot是Exalead的机器人的用户代理。该机器人创建了一个 “主索引”,汇编了搜索引擎用户将看到的结果。

10. Swiftbot

Swiftype是一个为你的网站定制的搜索引擎。它结合了 “最好的搜索技术、算法、内容摄取框架、客户端和分析工具”。

Swiftype是一个可以为你的网站搜索提供动力的软件

如果你有一个有许多页面的复杂网站,Swiftype提供了一个有用的界面,为你的所有页面编目和索引。

Swiftbot是Swiftype的网络爬行器。然而,与其他机器人不同,Swiftbot只抓取他们的客户要求的网站。

11. Slurp Bot

Slurp Bot是雅虎的搜索机器人,为雅虎抓取和索引网页。

Slurp Bot为雅虎的搜索引擎结果提供动力

这种抓取对于Yahoo.com以及其合作伙伴网站,包括Yahoo News、Yahoo Finance和Yahoo Sports,都是必不可少的。没有它,相关的网站列表就不会出现。

被索引的内容有助于为用户提供更加个性化的网络体验和更多的相关结果。

SEO专业人员需要知道的8个商业爬虫

现在你的爬虫名单上有11个最受欢迎的机器人,让我们来看看一些常见的商业爬虫和专业人员的SEO工具。

1. Ahrefs Bot

Ahrefs Bot是一个网络爬虫,它对流行的SEO软件Ahrefs提供的12万亿链接数据库进行汇编和索引。

Ahrefs Bot为SEO平台Ahrefs索引网站

Ahrefs Bot每天访问60亿个网站,被认为是仅次于Googlebot的 “第二大活跃爬虫”。

与其他机器人一样,Ahrefs Bot遵循robots.txt功能,以及每个网站代码中的允许/禁止规则。

2. Semrush Bot

Semrush Bot使Semrush(领先的搜索引擎软件)能够收集和索引网站数据,供其客户在其平台上使用。

Semrush Bot是Semrush用于索引网站的爬虫

这些数据用于Semrush的公共反向链接搜索引擎、网站审计工具、反向链接审计工具、链接建设工具和写作助手。

它通过汇编网页URL列表,访问它们,并保存某些超链接以供将来访问,从而爬行您的网站。

3. Moz活动爬虫Rogerbot

Rogerbot是领先的SEO网站Moz的爬虫。这个爬虫是专门为Moz Pro Campaign网站检测收集内容的。

Moz一个流行的SEO软件,部署了Rogerbot作为其爬虫

Rogerbot遵循robots.txt文件中规定的所有规则,因此你可以决定是否要阻止/允许Rogerbot扫描你的网站。

由于Rogerbot的多面性,网站管理员将无法通过搜索静态IP地址来查看Rogerbot抓取了哪些页面。

4. Screaming Frog

Screaming Frog是一个爬虫,SEO专业人员用它来检测自己的网站,并确定将影响其搜索引擎排名的改进领域。

Screaming Frog是一个有助于改善SEO爬虫

一旦开始爬行,您就可以审查实时数据,并确定无效的链接或需要对您的页面标题、元数据、机器人、重复内容等进行改进。

为了配置抓取参数,您必须购买一个Screaming Frog许可证。

5. Lumar (以前是Deep Crawl)

Lumar是一个 “维护您网站技术健康的集中指挥中心”。通过这个平台,您可以启动对网站的抓取,以帮助您规划网站的架构。

Deep Crawl已改名为Lumar,是一个网站智能爬行器

Lumar为自己是 “市场上最快的网站爬虫 “而自豪,并吹嘘说它每秒钟可以爬行450个URL。

6. Majestic

Majestic主要侧重于跟踪和识别URL的反向链接。

Majestic爬虫使SEO能够检测反向链接数据

该公司以拥有 “互联网上最全面的反向链接数据来源之一 “而自豪,强调其历史指数在2021年已从5年的链接增加到15年。

该网站的爬虫将所有这些数据提供给该公司的客户。

7. cognitiveSEO

cognitiveSEO是另一个重要的SEO软件,许多专业人士都在使用。

congnitiveSEO提供了一个强大的网站检测工具

cognitiveSEO爬虫使用户能够进行全面的网站检测,这将为他们的网站架构和总体的SEO战略提供信息。

该机器人将抓取所有页面,并提供 “完全定制的数据集”,这对最终用户来说是独一无二的。该数据集还将为用户提供建议,说明他们如何为其他爬虫改进网站–既影响排名,又阻止不必要的爬虫。

8. Oncrawl

Oncrawl是面向企业级客户的 “业界领先的SEO爬虫和日志分析器”。

Oncrawl是另一个提供独特数据的SEO爬虫软件

用户可以设置 “爬行配置文件”,为爬行创建特定参数。您可以保存这些设置(包括起始URL、抓取限制、最大抓取速度等),以便在相同的既定参数下轻松地再次运行抓取。

我是否需要保护我的网站免受恶意网络爬虫的侵害?

并非所有爬虫都是好的。有些可能会对您的页面速度产生负面影响,而有些则可能试图入侵您的网站或有恶意。

这就是为什么了解如何阻止爬虫进入您的网站很重要。

通过建立一个爬虫列表,你就会知道哪些爬虫是需要注意的好爬虫。然后,您就可以剔除那些可疑的爬虫,并将它们添加到您的拦截列表(WordPress可以通过Spider Analyser插件实现)中。

如何拦截恶意的网络爬虫

有了你的爬虫列表,你就能确定哪些是你想批准的机器人,哪些是你需要阻止的。

第一步是浏览您的爬虫列表,定义与每个爬虫相关的用户代理和全代理字符串,以及它的具体IP地址。这些是与每个机器人相关的关键识别因素。

有了用户代理和IP地址,您就可以通过DNS查询或IP匹配在您的网站记录中与之匹配(您可以通过我们提供蜘蛛查询工具,输入爬虫的IP地址,即可快速查询识别该IP地址是否来自真实的蜘蛛或者爬虫)。如果它们不完全匹配,你可能有一个恶意的机器人试图冒充真实的机器人。

然后,你可以通过使用 robots.txt 网站标签调整权限来阻止这个冒牌货,或者通过通过Spider Analyser插件快速拦截一切您不需要的蜘蛛爬虫。

小结

网络爬虫对搜索引擎很有用,对营销人员也很重要,需要了解。

确保您的网站被正确的爬虫正确抓取,对您的业务成功很重要。通过保留一个爬虫列表,您可以知道哪些爬虫出现在您的网站日志中时需要注意的。

当您遵循商业爬虫的建议,改进您网站的内容和速度时,您将使爬虫更容易访问您的网站,并为搜索引擎和寻求信息的消费者索引正确的信息。